2024年6月12日より3日間に渡って開催されたインターネットテクノロジーのイベント「Interop Tokyo 2024」にて、VMware が提供するプライベート AI 基盤「VMware Private AI Foundation with NVIDIA」が Best of Show Award のグランプリを受賞しました!今回は、その発表内容と VMware Private AI Foundation with NVIDIA の概要をお伝えします。

目次

- AIOps 部門でグランプリを受賞

- VMware Private AI Foundation with NVIDIA とは

- NVIDIA 社との共同開発

- AI 基盤でも価値を発揮する VMware Cloud Foundation (VCF)

- NVIDIA GPU を搭載した認定ハードウエア

- まとめ

AIOps 部門でグランプリを受賞

Interop Tokyo の「Best of Show Award」とは、Interop に出展する企業各社からエントリーされる選りすぐりの新製品を有力メディア各社のキーマンと学術界の識者によって編成される審査委員会が審査し、「今年の一品」を決定するものです。今年は168の新製品やサービスがエントリーされ、合計22部門に分かれて審査されました。その中の「AIOps 部門」にて「VMware Private AI Foundation with NVIDIA」がグランプリを受賞しました(写真1)。

写真1 受賞の様子

受賞理由として「LLM(大規模言語モデル)はユーザーが自由に選択でき、タスクに合わせて開発環境を仮想マシンとして提供しているため、すぐ開発に着手できること。また、vGPU の仮想マシン利用も最適で、貴重なリソースを共有して有効活用が図れている点を評価しました。」とアワード審査委員会よりコメントをいただきました。

VMware Private AI Foundation with NVIDIA とは

VMware Private AI Foundation with NVIDIA は、2024年5月から一般提供を開始した企業向けの生成 AI 基盤です(図1)。企業はデータセンターにプライベートな生成 AI 基盤を導入することで、プライバシーやセキュリティのリスクを回避しながら安全に AI アプリケーションを開発し、それを利用することができます。

図1 VMware Private AI Foundation with NVIDIA の全体像

VMware Private AI Foundation with NVIDIA を採用することで得られる企業の主なメリットは以下の通りです。NVIDIA社 と VMware のテクノロジーによって様々な価値を提供します。

- プライバシーの保護 : オンプレミスのプライベート環境に AI 基盤を配置するため、機密性の高いデータを外部に送信することなく安全に AI を活用できます

- 選択可能な LLM : NVIDIA NGC や Hugging Face などで提供されている LLM を活用してユースケースに特化した独自の生成 AI モデルを開発できます

- 性能の最大化 : データセンターに調達した限りある GPU リソースを効率的に活用し、モデル学習や推論環境において性能を最大限に発揮できます

- 基盤の拡張性 : 将来の需要に応じて柔軟に AI 基盤のリソースを追加および拡張できます

- 価値実現までの迅速化 : AI 開発や実行環境向けに活用できるライブラリや便利なツールを活用することで、基盤の導入から AI 開発の着手、およびビジネス活用までの時間を大幅に短縮し、Time-to-value(価値を実感するまでの時間)を迅速化できます

NVIDIA 社との共同開発

VMware Private AI Foundation with NVIDIA は、NVIDIA 社と VMware の協業に基づいて開発されました。生成 AI の登場で爆発的に需要が高まっている GPU の世界的リーディングカンパニーである NVIDIA 社と企業の IT 基盤において採用実績の豊富な VMware が協業し、一般企業における生成 AI の民主化を加速することを共通の目的として、プライベート AI 基盤である VMware Private AI Foundation with NVIDIA の提供を開始しました。

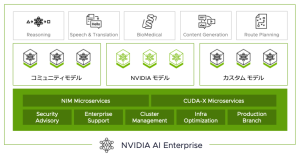

具体的な AI 開発には、NVIDIA 社が提供する「NVIDIA AI Enterprise」を主に利用します。NVIDIA AI Enterprise は、学習や推論、データ分析などの AI ワークロードを迅速に展開および管理できるソフトウェアプラットフォームです。エンタープライズグレードのセキュリティやサポート、安定性を備えた使いやすいマイクロサービスを提供し、AI でビジネスを展開する企業のプロトタイプ開発から本番稼働への円滑な移行を実現できます。

図2 NVIDIA AI Enterprise の概要

AI 基盤でも価値を発揮する VMware Cloud Foundation (VCF)

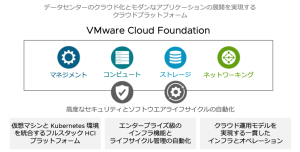

AI ワークロードの実行基盤には、VMware の統合ソフトウェアプラットフォームである「VMware Cloud Foundation」が採用されています。VMware Cloud Foundation は、プライベートクラウドに必要とされるあらゆる機能が備わっており、AI 基盤として採用する場合でも導入障壁を下げ、管理や運用に関わるエンジニアの負担を大幅に減らします。

図3 VMware Cloud Foundation の概要

VMware Private AI Foundation with NVIDIA のコンポーネントして VMware Cloud Foundation を活用する際に、今回新しく追加されたメリットをピックアップしてご紹介します。

- Deep Learning VM の提供 : AI モデルの学習環境や推論環境、RAG(検索拡張生成)環境または一時的な評価環境など、AI 開発を進める上でエンジニアは用途に応じて必要なライブラリやフレームワーク、ツールなどを準備する必要があります。これらの作業は煩雑で手間がかかります。VMware が提供する「Deep Learning VM」は、NVIDIA AI Enterprise をベースとした AI 開発や実行環境に必要なライブラリなどのソフトウェア一式を事前にテンプレートとして準備しておき、エンジニアが必要に応じていつでも展開できるようする仕組みです。これによって AI 開発に関わるエンジニアの生産性が大幅に向上します。

- Vector DB の提供 : LLM を 独自の AI 基盤でファインチューニングし、ビジネスで活用することを検討する際、RAG の併用も検討されることがあります。RAG 環境では LLM と外部検索データベースを組み合わせて LLM の回答精度を高める仕組みですが、そこで一般的にはベクトルデータベースが使用されます。VMware は VMware Cloud Foundation に実装されている DBaaS 機能(VMware Data Services Manager より提供)およびセルフサービス機能(Aria Automation より提供)によって、ベクトルデータベースを容易にデプロイできる仕組みを提供します。これによってエンジニアは RAG 向けデータベースの準備と運用工数を減らすことができます。

- カタログセットアップウィザードの提供 : VMware Cloud Foundation に実装されているセルフサービス機能では、利用者が簡単な操作で仮想マシンなどオンデマンドでデプロイできる仕組みを提供します。これは、事前に CPU やメモリなどの IT リソースのセットをカタログとして定義しておき、利用者向けのセルフサービスメニューと紐付けて実現します。VMware Private AI Foundation with NVIDIA では、容易にカタログを作成できるウィザードを提供することで IT 管理者の負担を減らします。

- GPU モニタリング機能の提供 : データセンターに GPU リソースを調達して AI 基盤として利用する場合、無駄なく GPU を活用することが費用対効果を最大化するカギになります。そのためには、限られた GPU リソースをうまく配分したり、問題発生時にも迅速に対処できる仕組みが必要です。そのアクションを支援するのが GPU のモニタリングです。VMware Cloud Foundation が提供する GPU モニタリング機能(Aria Operations より提供)は、GPU のコアやメモリの使用率、温度などの詳細な情報を収集するだけでなく、ヒートマップで全体を可視化したり、GPU とホストやクラスタなどの関連性を一目でわかるようなマップ情報を提供します。これらの機能は問題の特定やリソースの配分などに応用できるため、無駄なく GPU リソースを消費するツールとして活用できます。

NVIDIA GPU を搭載した認定ハードウエア

VMware Private AI Foundation with NVIDIA は、Dell 社や HPE 社など複数のベンダーから提供されている NVIDIA 社の GPU を搭載した認定サーバのモデルから選択して利用できます。サポート対象のベンダーとモデルは、VMware Private AI Foundation with NVIDIA Server Guidance で確認できます。サポート対象は今後も拡大する予定がありますので、今後のアップデートをお待ちください。

図 VMware Private AI Foundation with NVIDIA でサポートしているサーバモデル(2024年6月時点)

まとめ

今回は、Interop Tokyo 2024 Best of Show Award の AIOps 部門でグランプリを受賞した VMware Private AI Foundation with NVIDIA の概要についてお伝えしました。企業がデータセンター内にプライベートな AI 基盤を配備して、プライバシーやセキュリティに配慮しつつ独自の AI を開発する動きは今後も増加すると見込まれています。VMware Private AI Foundation with NVIDIA は、まさにそのようなニーズに最適なソリューションです。ぜひご検討ください。

関連情報リンク

- Interop Tokyo 2024 Best of Show Award 受賞企業一覧

- VMware Private AI Foundation with NVIDIA 製品ページ

- VMware Cloud Foundation 製品ページ

- NVIDIA AI Enterprise 製品ページ

- サポート対象のサーバモデル一覧(VMware Private AI Foundation with NVIDIA Server Guidance)

- VMware Private AI Foundation with NVIDIA – a Technical Overview(技術解説記事-英語版)