次世代のネットワークスタック技術である、Enhanced Datapath Standard(EDP Standard)について、本ブログでご紹介したいと思います。

VMware Cloud Foundation®(VCF) の一機能である EDP Standard は、ESXi 環境におけるパケット処理性能を大幅に向上させる次世代のネットワークスタック技術です。従来の標準データパスと比較して、EDP Standard はチューニング不要で即座に高いスループットと低レイテンシーを実現し、効率的な CPU リソース使用を可能にするテクノロジーです。

特に 100GbE NIC 環境でラインレートを達成し、1 コアあたりのパケット処理能力を最大化することで、企業のクラウドや NFV、AI プラットフォーム、エッジコンピューティングなど多様なワークロードに最適なネットワーク基盤を提供します。さらに、複数のCPUコアへの負荷分散やフローキャッシュ技術によって、高速かつ安定した通信を支え、運用の簡素化と CPU リソースに対するコスト削減にも EDP Standard は貢献します。

VMware Cloud Foundation® 9.0(VCF 9.0) からデファクトスタンダード(デフォルトで有効)となる EDP Standard により、最新の仮想化環境で求められる高性能・高効率なネットワークインフラの構築を強力にサポートします。そうした EDP Standard を支える技術要素や考慮点について、以下の目次の順番で解説します。

目次

- EDP Standardとは

- 従来の標準データパスとの違い

- フローキャッシュ技術によるパフォーマンス向上

- マルチキュー分散処理とRSS(Receive Side Scaling)の役割

- NetQueue RSS とMultiple Context

- 対応NICとドライバーの互換性について

- EDP Standard による性能評価(NSX Edge VM)

- EDP Standard による性能評価(VMware® Avi™ Load Balancer)

- vmknicやDFWへの影響とシナジー

- まとめ

-

-

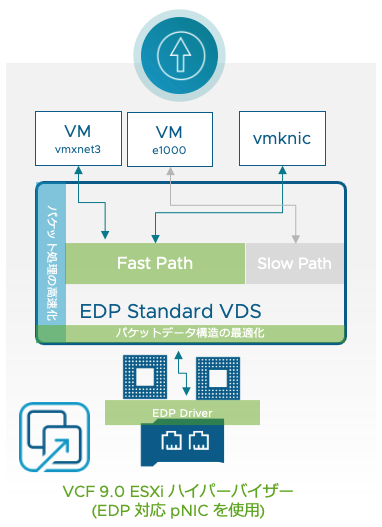

EDP Standard とは

EDP Standard は、従来の標準データパス(Standard Datapath)に代わる次世代のネットワーク処理アーキテクチャであり、ESXi ホスト上で動作する仮想スイッチ(VDS: vSphere Distributed Switch)に最適化されています。この技術は、物理 NIC(pNIC)のハードウェア機能を最大限に活用しながら、CPU リソースの使用効率を大幅に改善し、1コアあたりのパケット処理能力(pps: packets per second)を最大化します。その結果、100GbE などの高速ネットワーク環境でもラインレートの通信を実現し、低レイテンシーかつ高スループットのネットワークパフォーマンスをアウト・オブ・ボックス(すぐにご利用いただける)で提供できる点が大きな特徴です。

EDP Standard は複雑なチューニングを必要とせず、初期設定のままで高いパフォーマンスを発揮する「チューニングレス」設計となっているため、運用管理者の負担軽減にも寄与します。

複数の CPU コアへのパケット処理負荷分散やフローキャッシュ技術による高速化を実装し、動的かつ効率的に CPU リソースを割り当てることで、アイドル時には無駄な CPU 消費を抑えつつ、必要なタイミングで CPU コアを自動的に活用します。これにより、従来の標準データパスと比較して、仮想化環境全体のリソース効率が向上し、コスト削減にもつながります。

EDP は、NSX Manager のトランスポート ノード プロファイルでモード変更を行うことで有効化することができます。EDP は VCF 固有の機能となり、NSX 4.2.2.1 以降での利用が推奨されています。

EDP Standard は、一般的なコンピューティングワークロードだけでなく、NSX Edge VM や VMware® Avi™ Load Balancer、Telco NFV(Network Functions Virtualization)など多様なネットワークワークロードに対応可能であり、オーバーレイトラフィックと VLAN トラフィックの両方をサポートしています。これにより、最新のネットワーク仮想化技術と連携しながら、柔軟かつ高性能なネットワーク基盤を構築できます。

EDP Standard の特徴をリストすると、大まかに以下になります。

・省 CPU リソース(高効率)

・高性能(高スループット、高 PPS、低レイテンシー)

・フローキャッシュ技術の採用

・負荷に応じた動的 CPU リソースの割り当てと負荷分散

・物理NIC が有するマルチキューによる分散処理

・RSS ・ NetQueue RSS・Multiple Context 技術の採用

・チューニングレス -

従来の標準データパスとの違い

従来の標準データパスとEDP Standard との最大の違いは、パケット処理方式と CPU リソースの効率的な活用にあります。従来の標準データパスは主に割り込み駆動型(Interrupt mode)で動作し、IRQ (Interrupt Request) テクノロジー による割り込み処理を利用して必要に応じて CPU コアを使用しますが、パフォーマンス向上には複数のチューニングが必須であり、特定のワークロードでは一部のコアに負荷が偏る問題も存在しました。

EDP Standard は IRQ に加え、フローキャッシュ技術を導入し、パケット処理時の CPU 演算量を大幅に軽減しています。これにより、CPU コストを削減しつつコア単位のパケット処理能力を向上させています。また、マルチキュー分散処理と Receive Side Scaling(RSS)機能を活用し、pNIC が持つ複数のキューと CPU コア間で受信トラフィックを効率的に分散します。これにより、単一 CPU コアのパケット処理ボトルネックを解消し、全体のスループット性能を飛躍的に改善しています。

加えて、EDP Standard はチューニングレスで初期設定から高性能を発揮可能である点も大きな特徴です。NetQueue、 Receive Side Scaling (RSS)、 TCP Segmentation、Offload (TSO)、Large Receive Offload(LRO)、NUMA スケジューリングといった高度なネットワークパフォーマンステクノロジーと連携し自動構成されます。従来の標準データパスでは環境やワークロードに応じた細かな調整が求められましたが、EDP Standard は適切なドライバー選択だけでこれらのチューニング要素に対して最適化されており、運用の簡素化と安定したパフォーマンス提供を両立しています。

-

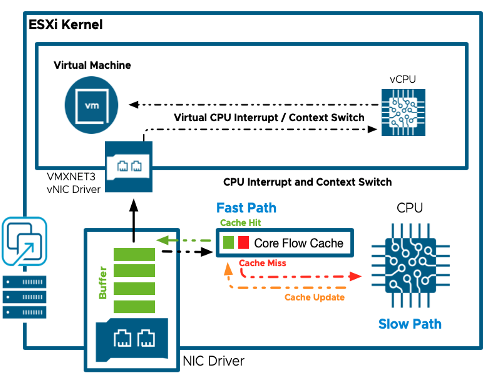

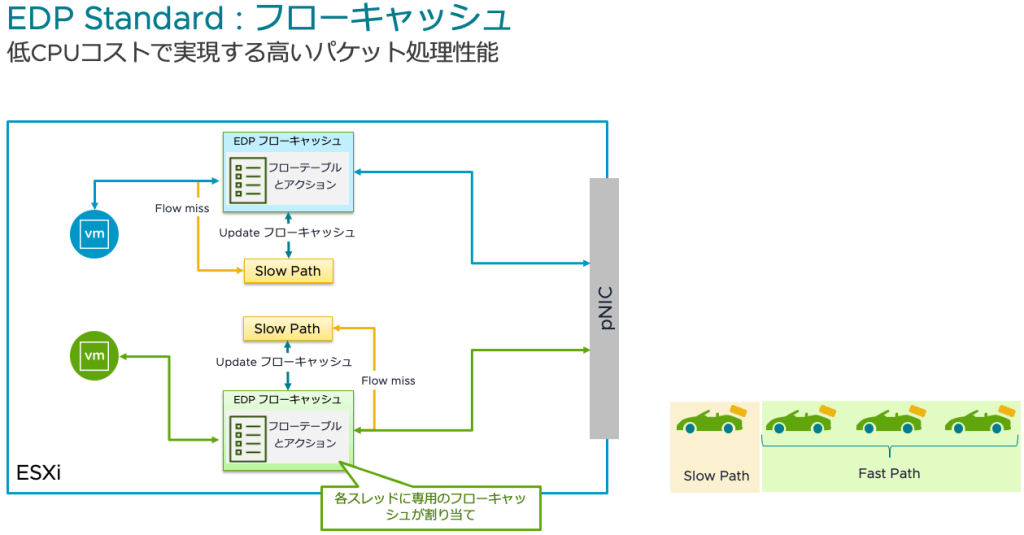

フローキャッシュ技術によるパフォーマンス向上

フローキャッシュ技術は、EDP Standard におけるパフォーマンス向上の中核的な要素であり、CPU リソースの効率的な活用と高速なパケット処理を実現するための重要な仕組みとなります。従来の標準データパスでは、すべてのパケットが逐一詳細な処理過程を通る必要があり、その都度 CPU 演算が発生していましたが、フローキャッシュはこれを最適化し、同一フローのパケット処理にかかる演算量を大幅に軽減します。

具体的には、ESXi ホスト上の各スレッドに専用のフローキャッシュが割り当てられ、フローテーブルとアクション情報を保持しています。初回のパケット処理時にフローキャッシュに登録されていないフロー(Flow miss/Cache miss)が発生すると、初回処理過程(Slow Path)で詳細な解析と処理が行われ、その結果がフローキャッシュに更新されます。その後、同じフローに属するパケットは高速処理経過程(Fast Path)を通過し、フローキャッシュ内の情報を参照することで迅速に処理されます。この仕組みにより、CPU 負荷を抑えつつ高いパケット処理性能を可能にします。

また、フローキャッシュは動的かつ効率的に CPU リソースを割り当てる設計となっており、アイドル状態のコアは無駄に消費されず、IRQ と連動し必要なタイミングでのみ使用されます。これにより、システム全体の省リソース効果も期待できます。さらに、複数のCPUコア間でフローキャッシュが分散管理されるため、特定のコアに負荷が集中することなく、均等にパケット処理が分散される点も特徴です。

このフローキャッシュ技術は、100GbE などの高速 pNIC の機能とも連携し、pNIC のマルチキュー分散処理や RSS 組み合わせることで、さらなるスケールアウトとパフォーマンス向上を実現しています。結果として、EDP Standard は従来比で50~70%のパフォーマンス改善を達成し、CPU コスト削減と高スループット・低レイテンシーの両立を可能にしています。(詳細なテスト結果は後述)

フローキャッシュ技術はパケットごとの詳細処理を繰り返すことなく、一度解析したフロー情報をキャッシュして再利用することで、CPU 負荷を大幅に軽減させます。高速かつ効率的なパケット転送を実現する重要な技術であり、EDP Standard の性能向上に不可欠な役割を果たしています。

-

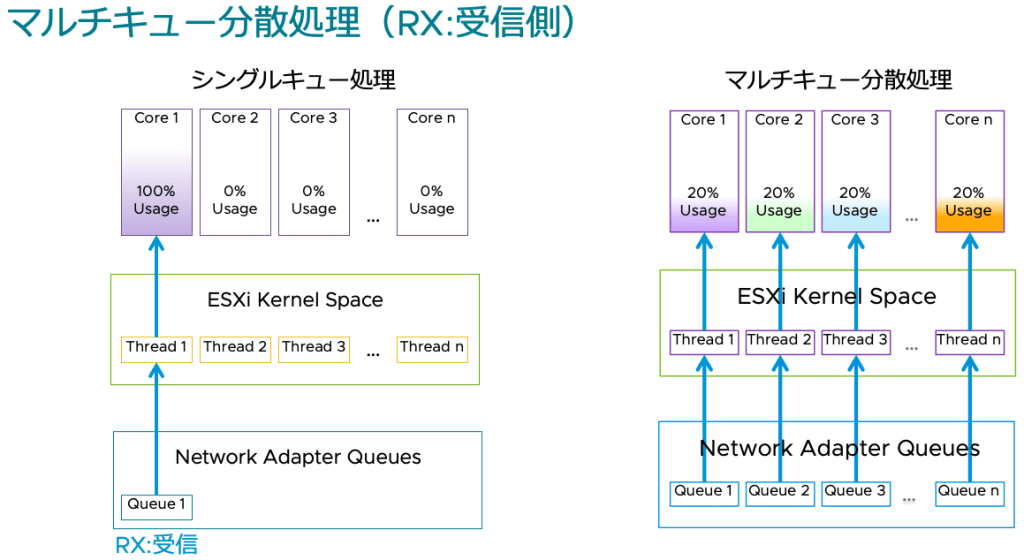

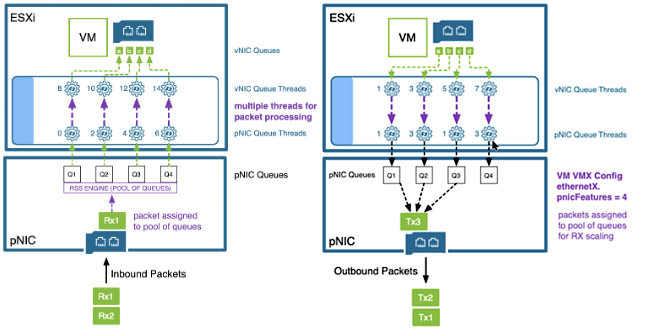

マルチキュー分散処理とRSS(Receive Side Scaling)の役割

マルチキュー分散処理と RSS は、EDP Standard におけるパケット処理性能向上の重要な技術要素であり、pNIC とホスト CPU コア間で効率的にトラフィックを分散させる役割を担っています。従来、pNIC の単一受信キューにパケットが集中すると、そのキューに対応する単一の CPU コアがボトルネックとなり、全体のスループット低下や CPU リソースの偏りが発生していました。これに対し、マルチキュー分散処理は pNIC の複数受信キューを活用し、それぞれを異なる CPU コアに割り当てることで負荷を均等化し、高い並列処理能力を実現します。

具体的には、pNIC は複数のハードウェアキューを持ち、各キューに到着したパケットを独立して処理することが可能です。RSS はこの複数キューへのパケット振り分け機能であり、パケットのヘッダー情報などに基づいて適切なキューへ振り分けることで、複数の CPU コアが同時にパケット処理を行えるようにします。EDP Standard モードでは、この RSS 機能がデフォルトで有効化されており、pNIC レイヤーだけでなく vNIC レイヤーでも複数のコアが自動的に割り当てられ、送受信トラフィックの管理が最適化されています。

また、EDP Standard では CPU 使用率に基づく動的なスレッドロードバランス機能が備わっており、CPU-usage モードによりコアの割り当てがリアルタイムで調整され、コアの過負荷やアイドル状態を防ぎつつ最適なパフォーマンスを維持します。この動的割り当ては、マルチキュー分散処理と RSS の効果を最大限に引き出すための重要な補完機能となります。

このように、マルチキュー分散処理と RSS は、複数の物理・論理キューと CPU コアを連携させてパケット処理を並列化し、単一コアのボトルネックを解消することで、EDP Standard の高スループット・低レイテンシー・効率的な CPU 利用を支える中核技術といえます。これにより、仮想化環境におけるネットワーク性能が飛躍的に向上し、安定した運用が可能となります。

-

NetQueue RSS のと Multiple Context

EDP Standard では、ネットワークパフォーマンスを最適化するためにさらに高度な以下2つの機能が提供されています。これらの機能は、仮想マシン(VM)に対するネットワーク処理能力をさらに向上させるために重要な技術です。

NetQueue RSS:受信パケット処理の並列化

NetQueue RSS は、複数の pNIC ハードウェアキューを束ねて一つの「RSS プール」として管理し、受信パケット(RX)の処理を複数の CPU コアに分散する機能です。これにより、パケット処理の効率化とスケーラビリティの向上が実現されます。

具体的には、vNIC レイヤーで複数のホスト CPU コアを活用し、受信トラフィックのパケット転送性能を大幅に改善します。ESXi ホストは複数の vNIC が同じスレッドを共有できるよう調整し、NetQueue RSS がこれらの要求を統合的に処理することも可能です。このため、多数の vNIC からの NetQueue RSS オフロード要求を効率的に処理し、高いネットワークパフォーマンスを維持することが可能です。

NetQueue RSS は、ベンダーやドライバーによってサポート状況が異なるため、最新の互換性情報を確認することが重要です。 (後述)

この機能が動作するには、仮想マシンの

.vmxファイルに以下のパラメータが設定されている必要があります。-

ethernetX.pnicFeatures = "4":vNIC で NetQueue RSS 機能を要求

Multiple Context:送受信パケット処理の並列化

Multiple Context は、vNIC ごとに複数の Context(スレッド)を割り当て、送受信パケットの処理を並列化する機能です。これにより、パフォーマンスの向上だけでなく、CPU リソースの効率的な利用が可能となります。

この機能が動作するには、仮想マシンの

.vmxファイルに以下のパラメータが設定されている必要があります。-

ethernetX.ctxPerDev = "3":vNIC キューごとに Multiple Context を適用

Multiple Context は、特に高スループットを要求するワークロードにおいて、送信および受信の両方のパフォーマンスを向上させるために有効です。

これらの機能は独立して動作しますが、同時に有効化することで、送信および受信の両方のパフォーマンスを最適化できます。特に、NSX Edge VM や Avi Service Engine VM などの高負荷なネットワークトラフィックを処理する仮想マシンでは、これらの機能を組み合わせることで、総合的なネットワーク性能の向上が期待できます。NSX Edge VM や Avi Service Engine VM は、上記のパラメータが設定された状態で通常はデプロイされており、EDP Standard の能力をシームレスに利用するように構成されています。

-

-

対応 pNIC とドライバーの互換性について

対応 pNIC とドライバーの互換性は、EDP Standard を適切に活用し、高性能なネットワーク処理を実現するための重要な要素です。EDP Standard は pNIC の機能を最大限に引き出す設計となっており、対応する pNIC とそれに合ったドライバーが必須となります。対応していない pNIC では、仮想スイッチは自動的に従来の標準データパスのモードへフォールバックし、EDP の高性能機能は利用できません。この場合でも従来の標準データパスとして正常に動作し、サポートされる構成ではありますが、パフォーマンス向上効果は限定的です。

具体的には、Broadcom、Intel®、NVIDIA® Mellanox® など主要ベンダーの NIC が EDP Standard に対応しており、それぞれ専用のドライバーが提供されています。例えば、Broadcom の bnxtnet ドライバーは最大4つの RSS エンジンを構成可能であり、各エンジンに8つのキューを割り当てることができます。機種によりますが、Mellanox® の nmlx5 ドライバーは最大8つの RSS エンジンをサポートします。これらのハードウェア特性やドライバー設定は、ロード時にデフォルトで有効化され、最適なパフォーマンスを発揮しますが、詳細な仕様や制限はベンダーや機種ごとに異なります。

ESXi に対する各メーカの pNIC の互換性確認は Broadcom の公式互換性ガイド(Broadcom Compatibility Guide)を通じて行うことが推奨されており、以下の URL から最新情報を参照可能です。

https://compatibilityguide.broadcom.com/search?program=io&persona=live製品 ID やリリースバージョン、ブランド名、対応機能などで絞り込み検索が可能です。これにより、VCF 9.0 環境下での特定 pNIC の EDP Standard (ガイドでは「Enhanced Data Path – Interrupt mode」と表記) の対応状況など詳細な情報を得られます。

EDP Standard を最大限に使い倒すには、対応 pNIC と正しいドライバーの選定・適用が不可欠であり、常に最新の互換性情報を確認しながら運用・導入を進める必要があります。これにより、高スループット・低レイテンシーかつ効率的な CPU 使用を実現し、仮想化環境のネットワーク性能を大幅に向上させることが可能となります。

-

EDP Standard による性能評価(NSX Edge VM)

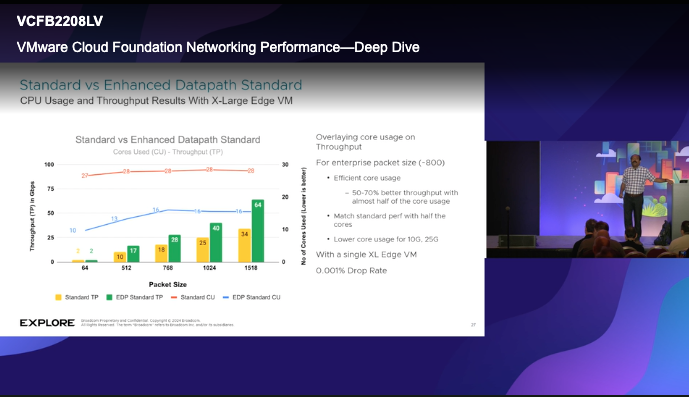

実際の性能試験結果と効果検証は、EDP Standard が仮想化環境においてどの程度のパフォーマンス向上をもたらすかを具体的に示す重要な指標です。こちらのセミナー講演では、特に NSX XL Edge VM を用いたテスト環境での評価が行われており、その詳細な構成や結果が報告されています。

試験環境は、ESXi 8.0.3 を搭載したサーバー上で、Intel® Xeon® Platinum 8480+ プロセッサ(56コア、2GHz)、1TB の RAM(DDR5 4400MHz)を備えています。ネットワークインターフェースカードには Mellanox® ConnectX®-5(MCX556A-EDAT100GbE)が使用され、ドライバーはバージョン 4.23.6.2、ファームウェアは 16.35.2000 が適用されています。トラフィック生成には IXIA AresONE(バージョン9.31.3201)が利用され、100GbE ポートを通じて UDP トラフィック(パケットサイズ約800バイト、ドロップ率0.001%)を送出しています。

性能比較では、従来の標準データパス と EDP Standard モードの両者を対象に、NIOC(Network I/O Control)は無効化し、従来の標準データパス側は広範囲なチューニングを施した状態で、EDP Standard は 初期設定(アウト・オブ・ボックス)で評価しました。その結果、EDP Standard は50~70%のスループット向上を達成し、パケット毎秒(pps)でも同様の改善が確認されています。また、CPU 使用率に関しては、ほぼ半分のコア数で同等以上のパフォーマンスを発揮し、10GE や 25GE 環境でも効率的なコア使用が可能であることが示されました。これにより、CPU リソースの節約と高いネットワーク処理能力の両立が実現されています。

このように、EDP Standard の導入により、pNIC の高度な機能を活用したマルチキュー分散処理や RSS エンジンの最適化が実現され、従来の標準データパスに比べて大幅なスループット向上、低レイテンシー、高効率な CPU 使用が可能となります。これらの性能試験結果は、企業の仮想化基盤やクラウドサービスにおけるネットワーク性能強化に直結し、信頼性の高い運用を支える根拠として非常に有用です。

-

EDP Standard による性能評価(VMware® Avi™ Load Balancer)

VMware® Avi™ Load Balancer においても、EDP Standard を活用することでネットワーク性能が向上したことが報告されています。こちらのデータシートでは、EDP Standard を有効化した環境では、従来の標準データパスに比べて VMware® Avi™ Load Balancer の大幅なパフォーマンス改善が確認されています。具体的には、NSX Cloud 環境下で複数の CPU コアとメモリ構成を持つAvi Service Engine(SE)仮想マシンを対象にテストが行われました。例えば、1コア/2GB RAM から 6 コア/12GB RAM までの構成で評価され、L4 レイヤーのスループットは最大 6Gbps から 16.5Gbps へ、L7 レイヤーのスループットも 5Gbps から 12Gbps へと大幅に向上しています。また、SSL 処理を伴う L7 スループットにおいても、2.6Gbps から 5Gbps へと約2倍の性能向上が見られています。この結果は、EDP Standard の割り込み駆動型ネットワークデータパスやフローキャッシュ技術、マルチキュー分散処理などの高度な機能が効果的に作用していることを示しています。

さらに、テスト環境には Intel® Xeon® Gold 6130 CPU 搭載サーバーと E810-C NIC が使用され、pNIC 速度は 25Gbps に制限された状態でのベンチマークとなっています

・VMware® Avi™ Load Balancer バージョン: 22.1.3-9096

・VMware NSX® バージョン: 4.0.0.1.0.20159689

・vCenter バージョン: 7.0.3

といった、上記の組み合わせで検証されており、EDP Standard (Interrupt mode) が有効化されたホスト上での実測値です。このように、VMware® Avi™ Load Balancer における EDP Standard の導入は、高度なネットワークトラフィック処理能力を必要とするクラウドサービスやエンタープライズ環境において、効率的かつ高性能なロードバランシングを実現し、運用コスト削減とユーザー体験の向上に寄与します。EDP Standard の適用により、CPU リソースの最適化とパケット処理の高速化が両立されるため、今後の仮想化ネットワーク基盤の重要な技術として期待されています。 -

vmknic や DFW への影響とシナジー

EDP Standard の導入はネットワーク処理効率の向上に寄与しつつ、それぞれのコンポーネントの動作特性を踏まえたメリットと留意点が存在します。vmknic に関しては、EDP Standard を有効化することで同等のパケット処理に必要な CPU コアの負荷が軽減され、処理効率が改善されます。具体的には、pNIC が十分な数の RSS エンジンを備えていれば、vmknic にも RSS キューがデフォルトで割り当てられ、高速なパケット処理が可能となります。ただし、TCP ベースのトラフィック(例:vMotion や vSAN)では、TSO(TCP Segmentation Offload)や LRO(Large Receive Offload)などの TCP 最適化機能の影響が大きいため、EDP Standard による vmknic のパフォーマンス向上は目に見える形で顕著ではありません。

一方、DFW(VMware 分散ファイアウォール) に関しては、EDP Standard の導入によって DFW 自体の必要リソース(CPU やメモリ)や動作ロジックに変更はなく、従来の標準データパスとの間で共通しています。しかしながら、パケットが pNIC や vNIC を経由して ESXi スイッチデータパス(VDS)に入り、DFW 処理に到達するまでの過程や処理プロセス部分はネットワークデータパスの性能向上の恩恵を受けます。つまり、DFW の処理能力やセッション数、ルール評価方式などの内部ロジックは変わらないものの、前段のネットワークデータパス処理が高速化されることで、結果的に DFW 処理に至るまでのレイテンシーが低減し、全体としてのパフォーマンス向上につながるシナジー効果が期待できます。

このように、EDP Standard は vmknic の CPU 負荷軽減と効率的な RSS 活用を促進し、DFW に対しては直接的なリソース増加なしにネットワークデータパスの高速化を通じて間接的な性能向上を実現します。このため、両者の連携により仮想化環境全体のネットワーク処理効率が高まり、運用面でも安定した高性能な通信基盤の構築に貢献します。

-

まとめ

本記事では、次世代ネットワークスタック技術 EDP Standard について、その特徴と利点を詳しく解説してきました。実際の性能評価においても、NSX Edge VM や VMware® Avi™ Load Balancer を対象に、スループット向上、CPU使用率削減といった具体的な効果が確認されており、最新の仮想化基盤におけるネットワーク性能の飛躍的な向上に寄与することが実証されています。

さらに、vmknic や DFW といった周辺コンポーネントとのシナジーにより、単なるネットワークデータパスの強化に留まらず、仮想化インフラ全体の効率向上と安定運用を支援します。VCF 9.0 以降、デフォルトで有効化される EDP Standard は、これからのクラウド基盤やAI、エッジコンピューティングといった多様なワークロードに対応するための強力な基盤技術となります。今後、仮想化基盤のネットワークのパフォーマンスと効率を求めるすべての組織にとって、 EDP Standard が欠かせない技術として末長くご活用いただけると幸いです。

-